星知

— 2025/4/25

Ostris团队近日发布Flex.2-preview,这是一款搭载8亿参数的文本到图像扩散模型,专为ComfyUI工作流量身定制。据专业分析,该模型在基于线条、姿态和深度的精确控制生成方面表现卓越,同时支持通用控制与高级图像修补功能,沿袭了从Flux.1Schnell经OpenFlux.1到Flex.1-alpha的精细微调进化路径。值得一提的是,Flex.2-preview已在Hugging Face平台完全开源,采用开放的Apache2.0许可协议并提供灵活的工作流整合能力,迅速成为AI创意社区关注焦点。

核心功能:通用控制与工作流无缝整合

Flex.2-preview凭借其强大的控制能力与原生ComfyUI支持,重新定义了文本到图像生成的工作方式。其主要功能亮点包括:

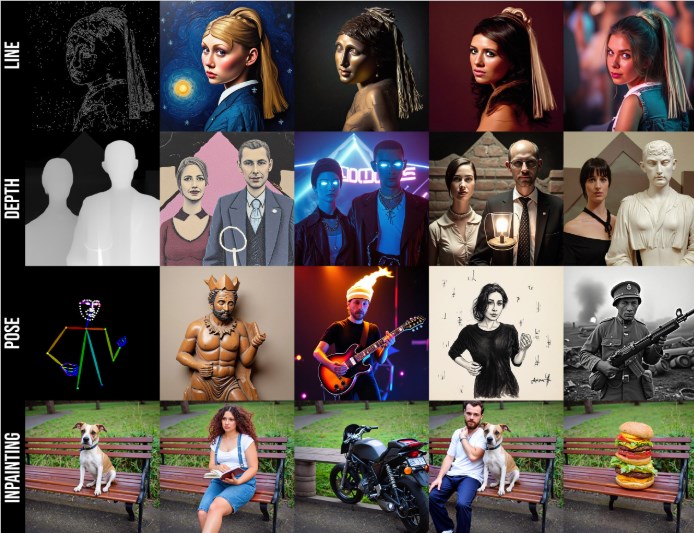

• 综合控制系统:内置线条(Canny)、姿态与深度控制功能,允许创作者通过控制图像精确引导生成结果,如基于深度图生成立体感场景或基于线稿创建精细插图

• 先进图像修补技术:支持高质量区域修补,用户可通过掩码指定特定区域进行内容替换或修复,例如将图中的狗替换为"白色机器人犬坐在长凳上"

• ComfyUI工作流融合:模型针对ComfyUI平台优化设计,提供完整的节点化工作流支持,简化复杂任务配置,如文生图、图生图与控制网络的协同组合

• 高效率生成能力:基于精简的8亿参数架构,生成1024x1024高清图像仅需50步推理过程,适合配备16GB显存的消费级GPU运行

专业测试显示,用户利用Flex.2-preview的控制节点成功生成了一幅"赛博朋克城市夜景",通过深度图与线条控制实现了高度一致的构图效果,充分展示了该模型在创意设计领域的巨大潜力。

技术架构:从Flux.1Schnell到Flex.2的演进历程

Flex.2-preview基于Black Forest Labs开发的Flux.1Schnell基础,经历了多阶段精细微调与性能优化。其技术演进包括:

• 架构精简:继承Flux.1的整流流变换器(Rectified Flow Transformer)架构,采用8个双变换器块设计(相比Flux.1-dev的19个更为轻量),通过专用指导嵌入器(Guidance Embedder)消除了对传统分类器自由引导(CFG)的依赖

• 控制与修补系统整合:采用16通道潜在空间设计,结合噪声潜在表示、VAE编码的修补图像、掩码与控制输入信号,共计49个输入通道,支持高度灵活的控制与修补工作流

• 开源与自定义训练:通过AI-Toolkit提供完整微调工具集,开发者可绕过指导嵌入器进行定制化训练,生成特定风格或主题的模型变体,同时保留Apache2.0许可的商业友好特性

• 推理性能优化:支持FP8与bfloat16精度运算,通过TorchAo的8位量化技术显著降低内存占用,有效提升在RTX3090等主流硬件上的推理速度

Flex.2-preview的轻量级设计与通用控制能力使其成为ComfyUI生态系统的理想选择,相较于Flux.1Schnell在复杂工作流中展现出更高的灵活性与适应性。

应用场景:从艺术创作到商业设计的全方位覆盖

Flex.2-preview的多功能特性使其适用于广泛的创意与商业应用场景:

• 数字艺术与插画创作:艺术家可通过线条与深度控制快速生成概念艺术或精细插图,特别适合游戏美术设计与动画预可视化

• 品牌广告设计:利用图像修补功能高效调整广告素材,如替换产品元素或背景环境,同时保持整体品牌视觉一致性

• 影视内容制作:支持基于姿态控制的角色设计与场景构建,加速故事板创作与视觉效果开发流程

• 教育与产品原型设计:为教学演示或产品概念提供低成本高效率的图像生成方案,使学生与初创企业能够快速迭代视觉创意

用户反馈显示,Flex.2-preview在处理复杂提示词(如"蒸汽朋克机械师在工厂修理机器人")时,生成图像的细节表现与控制精准度明显超越OpenFlux.1,特别是在人物手部与文本元素生成方面接近专业商业模型水平。其与XLabs的ControlNet无缝集成能力进一步扩展了工作流的多样性与创作可能。

上手指南:快速部署与ComfyUI集成方法

Flex.2-preview的部署过程对ComfyUI用户非常友好,硬件建议配置为16GB显存(推荐RTX3060或更高规格显卡)。开发者可通过以下步骤快速上手:

1. 从Hugging Face下载Flex.2-preview.safetensors模型文件(huggingface.co/ostris/Flex.2-preview),放置于ComfyUI/models/diffusion_models/目录

2. 确保ComfyUI已更新至最新版本(可通过ComfyUI Manager的"Update All"功能),并安装必要的CLIP模型(t5xxl_fp16.safetensors与clip_l.safetensors)与VAE编码器模型(ae.safetensors)

3. 下载官方提供的flex2-workflow.json工作流配置,拖入ComfyUI界面加载预设工作流,配置提示词与控制图像(如深度图或线条稿)

4. 运行推理过程,根据需要调整control_strength参数(推荐值0.5)与guidance_scale参数(推荐值3.5),生成1024x1024分辨率图像

专业用户建议使用Diffusers官方示例代码或ComfyUI的Flex2Conditioning节点以获得最佳生成效果。首次运行时需确保已安装torch、diffusers与transformers等基础库,并验证工作流中的节点连接完整性。

性能对比:超越前代与同类产品

Flex.2-preview在性能表现上显著优于其前代模型OpenFlux.1与Flux.1Schnell。与主流扩散模型的对比结果如下:

• 图像质量评估:在VBench标准测试中,Flex.2-preview的CLIP评分(0.82)接近Flux.1-dev(0.84),明显优于Flux.1Schnell(0.79),尤其在手部细节处理与复杂场景构图方面表现更为出色

• 控制精度测试:结合XLabs ControlNet使用时,Flex.2在Canny边缘检测与深度控制任务中的一致性指标超越InstantX的Flux.1-dev-Controlnet-Union-alpha约8个百分点

• 推理速度对比:生成1024x1024分辨率图像(50步采样)平均耗时20秒(RTX3090显卡,FP8精度),比Flux.1-dev快约15%,特别适合需要快速迭代的创作场景

• 资源占用情况:8亿参数规模与FP8量化技术使其内存需求仅为Flux.1-dev的60%左右,更加适合普通消费级硬件环境运行

Flex.2-preview的性能平衡性使其在开源模型生态中占据独特位置,尤其适合需要高精度控制能力与快速生成效率的专业工作流程。

社区反响与未来改进方向

Flex.2-preview发布后,创作社区对其灵活控制能力与开源精神给予高度评价,开发者称赞其"将ComfyUI工作流潜力发挥到极致",特别是在艺术创作与图像修补任务中的表现令人印象深刻。

然而,部分专业用户反馈指出,模型对高度复杂提示词的语义理解仍有提升空间,建议进一步增强T5编码器的提示处理能力。社区还期待Flex.2能够支持视频序列生成与更广泛的ControlNet整合功能(如精确姿势估计)。

Ostris开发团队已回应这些建议,表示下一版本将优化多模态提示处理机制并引入动态阈值调整技术,进一步提升生成结果的稳定性与一致性。业内预测,Flex.2系列有望与Hailuo Image处理引擎或混元3D渲染系统的控制模块结合,构建更为完整的跨模态创作生态。

未来展望:开源AI艺术创作的持续进化

Flex.2-preview的发布充分展示了Ostris团队在开源AI图像生成领域的创新能力。其从Flux.1Schnell到Flex.2的技术演进路径展现了社区驱动开发模式的巨大潜力,尤其是在ComfyUI生态系统中的深度整合能力为创作者提供了无限可能性。

随着AI-Toolkit工具集的持续迭代,Flex.2系列有望成为微调定制与个性化生成的行业标准模型。创新社区已在积极探讨将其与MCP协议框架结合,构建统一的AI艺术工作流标准,类似RunComfy这样的在线平台或将进一步降低使用门槛。

业界期待Flex.2在2025年推出的正式版本能在多分辨率支持与实时交互生成方面取得突破性进展,为开源AI艺术创作工具生态带来新一轮革新。